人工智能系统在不断发展。机器学习模型从数据和经验中学习,一旦它们被发布到现实世界中,就需要不断地对它们进行监视、测试和再培训。它还需要建立道德和负责任的框架。仅仅因为人工智能的初衷是好的,并不意味着现实世界的应用程序会按计划进行。一个令人心酸的例子是,蓝冠怎么样?为5G创建多SIM卡解决方案会给LTE带来新的设计挑战。蓝冠官网在5G部署中,不仅需要为同一设备上的一张SIM卡而且需要两张SIM卡支持新的RF频段和网络配置。微软(Microsoft) 2016年推出的聊天机器人Tay遭遇了尴尬的失败。在它发布的一天之内,人们就教会了这个基于twitter的机器人种族主义和厌女症。这种糟糕的公众行为不仅损害了微软的品牌,而且在人们如何看待人工智能方面产生了巨大的社会影响。这显然是一个意外后果的案例。

在开发和/或实施人工智能时,组织的重点需要放在如何创建一种智能,这种智能能够做它想做的事情。在微软的例子中,没有人受伤或死亡,机器人能够迅速关闭,而后果却很小,但随着我们开始越来越依赖人工智能,这是一个很大的可能性。

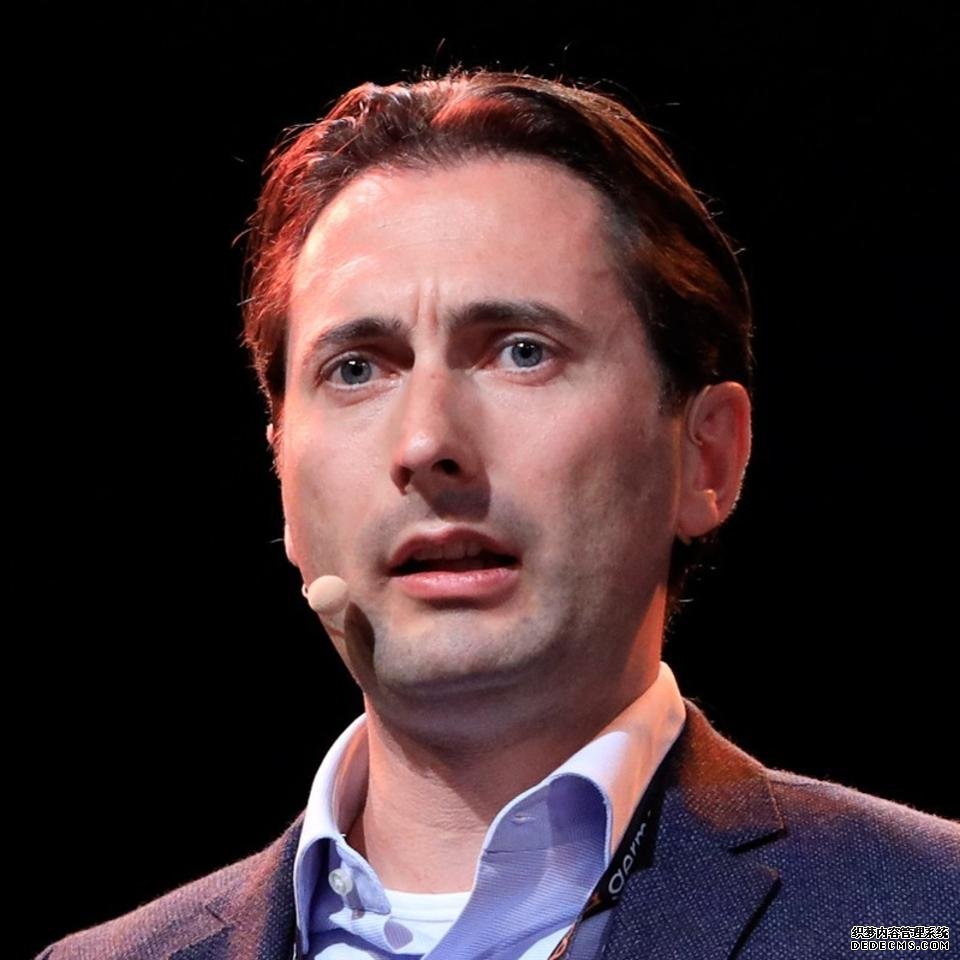

在最近一期的AI Today播客中,Datafloq的创始人、区块链研究所的教员和公共演讲者Mark van Rijmenam分享了人工智能系统在责任和伦理环境下如何发展的见解。马克正在悉尼科技大学攻读博士学位,他在那里研究人工智能等技术如何影响组织和企业。他的专业领域是区块链、大数据和人工智能。然而,马克最大的关注点是研究技术如何影响社会方面和组织,尤其是负责任的人工智能。

马克认为,人工智能系统的可解释性是我们构建对其结果和行为负责的人工智能系统的一种方式。前提是,一个负责任的人工智能应该记录下它所做的每一件事,以及它做出决定的原因,因此,如果发生了什么事情,人类可以在一些意想不到的事情发生后返回,看看系统为什么会做出这样的决定。马克举了一个自动驾驶汽车撞墙的例子。在汽车撞到墙上后,调查人员应该能够询问车内的人工智能为什么撞到墙上,而不是采取另一个行动。人工智能应该能够以一种可以理解的方式做出回应,即它之所以撞到墙上,是因为一个特定的原因,或者是因为某些特定的事情发生了。

在当今世界,了解计算机如何以及为什么要做出决策是非常重要的。我们有汽车、飞机和无人机,它们部分或全部由人工智能控制。尽管我们需要可解释的人工智能,但在技术上,我们还无法做到这一点,尤其是对于缺乏透明度的算法,如深度学习。现在,在一个涉及人工智能的事件之后,我们必须让一个人通过代码,并试图找出发生了什么。这是具有挑战性的。

另一种对抗人工智能系统意外失败并从过去的人工智能实验中吸取教训的方法是将伦理灌输到我们的人工智能中。向人工智能教授伦理道德的问题在于,我们首先必须就什么是“好”、什么是“坏”达成共识。对于许多特定的问题,比如盗窃或谋杀,我们作为社会可以就什么是好,什么是坏达成一致,蓝冠注册AI正在通过自然语言处理来帮助驱动各种形式的机器人,以帮助人类。例如,机器人可以用来将饮料运送到酒店房间,或将比萨饼运送到房屋,同时让接收者提出问题以获取信息。但当涉及到更微妙的、哲学方面的问题时,不是每个人都能达成一致。此外,道德和伦理的许多方面都是文化的,因此,随着这些人工智能系统在世界不同地区以及与具有不同文化或宗教观点的人进行交互,事情会变得更加复杂。

当我们看到负责任的、可解释的人工智能时,需要注意的一件重要事情是,我们正在进入一个人工智能不必由人类来教如何做事的世界。人工智能现在可以学习如何独立完成各种任务。谷歌的DeepMind开发了AlphaGo。这套系统学会了自己玩围棋,而且玩得非常好,甚至打败了世界上最好的人类棋手李世石(Lee Sedol)。

一个糟糕的人工智能系统可以被控制吗?

许多担心超级智能系统或恶意使用人工智能系统的人认为,应该采取一些控制措施来关闭那些迅速失控的人工智能系统,比如Tay机器人。控制措施可以归结为人工智能pr中内置的管理规则,甚至创建一个可以快速关闭人工智能系统的“关闭开关”。在Facebook的人工智能机器人实验中,该公司最终不得不终止机器人,因为它开始用一种难以理解的语言交流。这种新的语言对于机器人之间的交流更加有效,但人类却无法理解机器人。这又是一个意外后果的例子。

在马克看来,当涉及到人工智能系统时,很少有公司会审查他们的代码或做出重大努力来负责任。然而,谷歌的DeepMind就是一家做得很好的公司。Mark认为这个谷歌项目是世界领先的人工智能公司之一。DeepMind成立了一个研究部门,团队成员约25人,主要关注人工智能伦理。

人工智能责任是一个大问题,因为我们在日常生活中越来越依赖这些系统。我们的活动越来越多地依赖于机器学习系统,而机器学习系统令人不安地缺乏责任感。这些系统有时几乎没有人为的控制或监督,在这种情况下,我们应该更加关注。随着企业将人工智能、区块链、大数据等技术视为竞争优势,蓝冠测速网络用于移动设备通信,因为射频是一种有限的共享资源,并且蓝冠官网体系结构已被设计为在广泛的地理区域内和许多设备之间共享此资源。它们将越来越多地利用这些变革性技术,而较少考虑安全性和责任。基于这些原因,组织考虑AI的道德和负责任的使用来降低这些系统意外后果的风险是很重要的。一旦有了这些系统,简单地拉动“自杀开关”可能就不那么容易或可行了。